Depuis le début du 20e siècle, les scientifiques et les physiciens ont été chargés d'expliquer comment et pourquoi l'Univers semble se développer à un rythme accéléré. En plus d'être responsable de l'accélération cosmique, cette énergie représenterait également 68,3% de la masse non visible de l'univers.

Tout comme la matière noire, l'existence de cette force invisible est basée sur des phénomènes observables et parce qu'elle correspond à nos modèles actuels de cosmologie, et non à des preuves directes. Au lieu de cela, les scientifiques doivent s'appuyer sur des observations indirectes, en observant la vitesse à laquelle les objets cosmiques (en particulier les supernovae de type Ia) s'éloignent de nous à mesure que l'univers se développe.

Ce processus serait extrêmement fastidieux pour les scientifiques - comme ceux qui travaillent pour le Dark Energy Survey (DES) - sans les nouveaux algorithmes développés en collaboration par des chercheurs du Lawrence Berkeley National Laboratory et de l'UC Berkeley.

«Notre algorithme peut classer la détection d'un candidat à la supernova en environ 0,01 seconde, tandis qu'un scanner humain expérimenté peut prendre plusieurs secondes», a déclaré Danny Goldstein, un étudiant diplômé de l'Université de Californie à Berkeley qui a développé le code pour automatiser le processus de découverte de la supernova sur les images DES. .

Actuellement dans sa deuxième saison, le DES prend des photos nocturnes du ciel du Sud avec DECam - un appareil photo de 570 mégapixels qui est monté sur le télescope Victor M. Blanco au Cerro Tololo Interamerican Observatory (CTIO) dans les Andes chiliennes. Chaque nuit, la caméra génère entre 100 gigaoctets (Go) et 1 téraoctet (To) de données d'imagerie, qui sont envoyées au National Center for Supercomputing Applications (NCSA) et au Fermilab du DOE en Illinois pour le traitement initial et l'archivage.

Les programmes de reconnaissance d'objets développés au National Energy Research Scientific Computing Center (NERSC) et mis en œuvre au NCSA examinent ensuite les images à la recherche d'éventuelles détections de supernovae de type Ia. Ces explosions puissantes se produisent dans des systèmes d'étoiles binaires où une étoile est une naine blanche, qui accréte le matériau d'une étoile compagnon jusqu'à ce qu'elle atteigne une masse critique et explose dans une supernova de type Ia.

«Ces explosions sont remarquables car elles peuvent être utilisées comme indicateurs de distance cosmique avec une précision de 3 à 10%», explique Goldstein.

La distance est importante car plus un objet est éloigné dans l'espace, plus il remonte dans le temps. En suivant les supernovae de type Ia à différentes distances, les chercheurs peuvent mesurer l'expansion cosmique à travers l'histoire de l'univers. Cela leur permet de restreindre la vitesse à laquelle l'univers se développe et peut-être même de fournir d'autres indices sur la nature de l'énergie sombre.

«Scientifiquement, c'est une période vraiment excitante parce que plusieurs groupes à travers le monde essaient de mesurer précisément les supernovae de type Ia afin de contraindre et de comprendre l'énergie sombre qui entraîne l'expansion accélérée de l'univers», explique Goldstein, qui est également étudiant. chercheur au centre de cosmologie computationnelle de Berkeley Lab (C3).

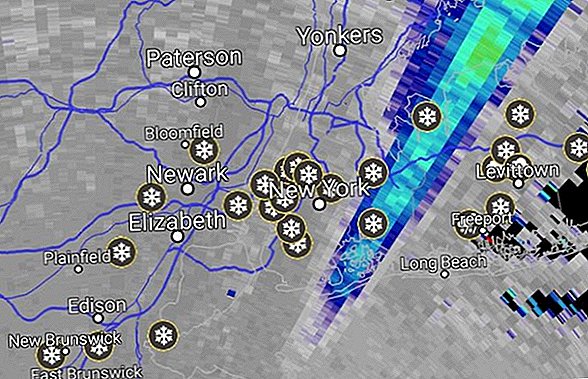

Le DES commence sa recherche d'explosions de type Ia en découvrant les changements dans le ciel nocturne, où le pipeline de soustraction d'images développé et mis en œuvre par les chercheurs du groupe de travail DES supernova entre en jeu. Le pipeline soustrait les images qui contiennent des objets cosmiques connus des nouvelles images qui sont exposés tous les soirs au CTIO.

Chaque soir, le pipeline produit entre 10 000 et quelques centaines de milliers de détections de candidats supernova qui doivent être validés.

«Historiquement, des astronomes entraînés restaient assis devant l'ordinateur pendant des heures, regardaient ces points et proposaient s'ils avaient les caractéristiques d'une supernova ou s'ils étaient causés par des effets parasites qui se faisaient passer pour des supernovae dans les données. Ce processus semble simple jusqu'à ce que vous réalisiez que le nombre de candidats qui doivent être classés chaque nuit est prohibitif et qu'un seul sur quelques centaines est une véritable supernova de tout type », explique Goldstein. «Ce processus est extrêmement fastidieux et prend beaucoup de temps. Cela met également beaucoup de pression sur le groupe de travail de supernova pour traiter et analyser les données rapidement, ce qui est un travail difficile. »

Pour simplifier la tâche de vérification des candidats, Goldstein a développé un code qui utilise la technique d'apprentissage automatique "Random Forest" pour contrôler automatiquement et en temps réel les détections de candidats supernova pour les optimiser pour le DES. La technique utilise un ensemble d'arbres de décision pour poser automatiquement les types de questions que les astronomes considéreraient généralement lors de la classification des candidats à la supernova.

A la fin du processus, chaque détection d'un candidat se voit attribuer un score basé sur la fraction d'arbres de décision qui la considéraient comme ayant les caractéristiques d'une détection d'une supernova. Plus le score de classement est proche de un, plus le candidat est fort. Goldstein note que lors des tests préliminaires, le pipeline de classification a atteint une précision globale de 96%.

«Lorsque vous effectuez une soustraction seule, vous obtenez beaucoup trop de« faux positifs »- des artefacts instrumentaux ou logiciels qui se présentent comme des candidats potentiels à la supernova - pour que les humains les filtrent», explique Rollin Thomas, du C3 de Berkeley Lab, qui était le collaborateur de Goldstein.

Il note qu'avec le classificateur, les chercheurs peuvent filtrer rapidement et avec précision les artefacts des candidats supernova. «Cela signifie qu'au lieu d'avoir 20 scientifiques du groupe de travail sur les supernovaes passant au crible en permanence des milliers de candidats chaque soir, vous pouvez simplement nommer une personne pour examiner peut-être quelques centaines de candidats solides», explique Thomas. «Cela accélère considérablement notre flux de travail et nous permet d'identifier les supernovae en temps réel, ce qui est crucial pour effectuer des observations de suivi.»

«En utilisant environ 60 cœurs sur un supercalculateur, nous pouvons classer 200 000 détections en environ 20 minutes, y compris le temps d'interaction avec la base de données et d'extraction de fonctionnalités.» dit Goldstein.

Goldstein et Thomas notent que la prochaine étape de ce travail consiste à ajouter un deuxième niveau d'apprentissage automatique au pipeline pour améliorer la précision de la classification. Cette couche supplémentaire tiendrait compte de la façon dont l'objet a été classé dans les observations précédentes car elle détermine la probabilité que le candidat soit «réel». Les chercheurs et leurs collègues travaillent actuellement sur différentes approches pour atteindre cette capacité.